DeepSeek 不同版本模型硬件要求

以下是 DeepSeek 不同版本模型的硬件要求,小伙伴们可以结合自己电脑配置选择版本

| 模型版本 | 参数量 | 显存需求(FP16) | 推荐 GPU(单卡) | 多卡支持 | 量化支持 | 适用场景 |

|---|---|---|---|---|---|---|

| DeepSeek-R1-1.5B | 15亿 | 3GB | GTX 1650(4GB显存) | 无需 | 支持 | 低资源设备部署(树莓派、旧款笔记本)、实时文本生成、嵌入式系统 |

| DeepSeek-R1-7B | 70亿 | 14GB | RTX 3070/4060(8GB显存) | 可选 | 支持 | 中等复杂度任务(文本摘要、翻译)、轻量级多轮对话系统 |

| DeepSeek-R1-8B | 80亿 | 16GB | RTX 4070(12GB显存) | 可选 | 支持 | 需更高精度的轻量级任务(代码生成、逻辑推理) |

| DeepSeek-R1-14B | 140亿 | 32GB | RTX 4090/A5000(16GB显存) | 推荐 | 支持 | 企业级复杂任务(合同分析、报告生成)、长文本理解与生成 |

| DeepSeek-R1-32B | 320亿 | 64GB | A100 40GB(24GB显存) | 推荐 | 支持 | 高精度专业领域任务(医疗/法律咨询)、多模态任务预处理 |

| DeepSeek-R1-70B | 700亿 | 140GB | 2x A100 80GB/4x RTX 4090(多卡并行) | 必需 | 支持 | 科研机构/大型企业(金融预测、大规模数据分析)、高复杂度生成任务 |

| DeepSeek-671B | 6710亿 | 512GB+(单卡显存需求极高,通常需要多节点分布式训练) | 8x A100/H100(服务器集群) | 必需 | 支持 | 国家级/超大规模 AI 研究(气候建模、基因组分析)、通用人工智能(AGI)探索 |

部署步骤

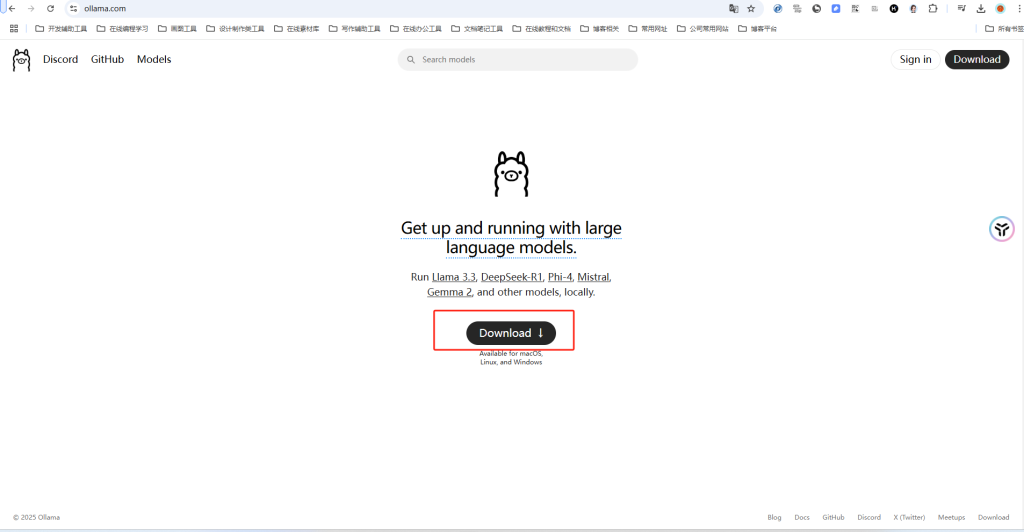

下载并安装Ollama

访问官网:https://ollama.com/ 下载

或者直接到GitHub下载。安装文件OllamaSetup.exe大约745MB。

双击OllamaSetup.exe进行安装:

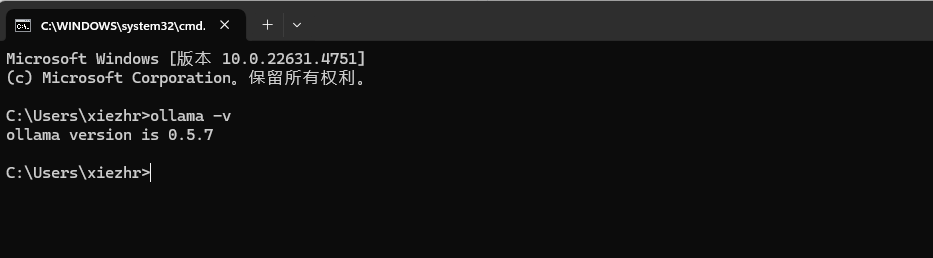

检验Ollama是否安装成功

命令行输入 ollama -v 命令,出现如下版本号说明安装成功

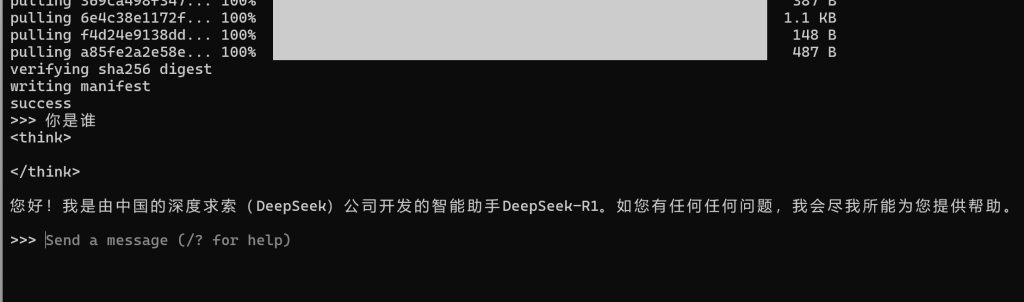

通过 Ollama 拉取 DeepSeek 模型

这里我选择是的1.5b,整个模型大小1.1 GB。

- 1.5B:适用于轻量级任务,如边缘设备(如智能手表、物联网设备)上的简单交互、小型智能问答系统等。目前开源的最小版本。

- 671B:主要用于大规模云端推理,适合科研分析、数据挖掘等需要处理海量数据的复杂任务。目前开源的最强版本

DeepSeek-R1-Distill-Qwen-1.5B

ollama run deepseek-r1:1.5b

DeepSeek-R1-Distill-Qwen-7B

ollama run deepseek-r1:7b

DeepSeek-R1-Distill-Llama-8B

ollama run deepseek-r1:8b

DeepSeek-R1-Distill-Qwen-14B

ollama run deepseek-r1:14b

DeepSeek-R1-Distill-Qwen-32B

ollama run deepseek-r1:32b

DeepSeek-R1-Distill-Llama-70B

ollama run deepseek-r1:70b命令行输入:ollama run deepseek-r1:1.5b 拉取DeepSeek模型

与DeepSeek对话

通过上面步骤之后,我们就可以愉快的与Deep Seek对话了

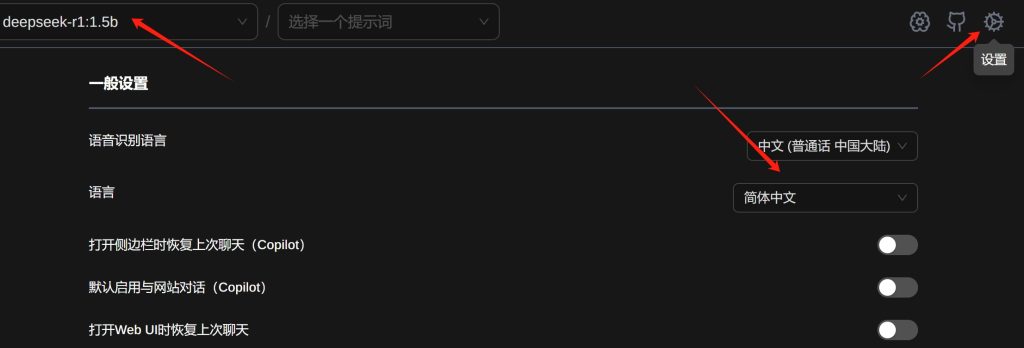

安装WebUI

使用命令提示符与DeepSeek对话并不友好,为了更好的体验,我们可以安装WebUI,这里使用的是浏览器插件:Page Assit

刚安装Page Assit 插件, 需要进行一下如下设置

右上角设置里修改好语言,主页选择模型就可以开始对话,而且支持基础的联网搜索,玩法也更多样。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END

- 最新

- 最热

只看作者